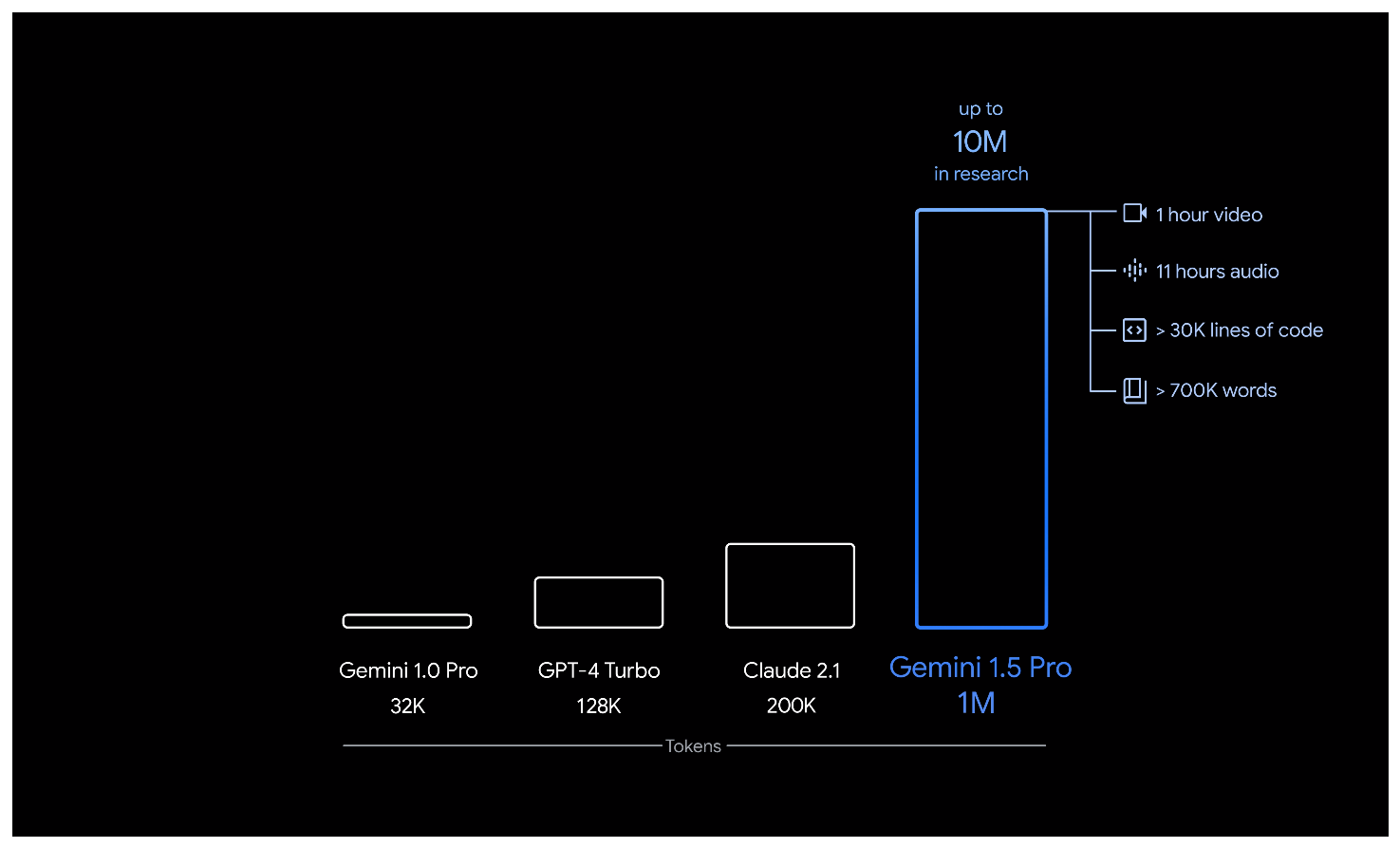

今天 Google 發表了最新的 AI 模型 Gemini 1.5,不只提高模型訓練和服務效率,而且擁有更強大的理解力,每次能處理的 token 長度更是一口氣突破 100 萬大關,是競爭對手 GPT-4 的 7.8 倍 (GPT-4 目前只提供最長 32K 長度),可以處理更大量的資訊,也擁有更大的「腦容量」。

支援高達 100 萬 token,可以進行更複雜的任務

Gemini 1.5 和前一代同樣是屬於多模態的 AI 模型,今天發布 Gemini 1.5 Pro 在 Google 的定義是屬於中型 AI 模型,但它的能力已與 Gemini 1.0 Ultra 相當。最大的突破是一口氣將模型可以處理的資訊量提升到 1,000,000 個 token,這是目前所有 AI 語言模型中最大規模的容納量。

你可以將單次能處理的 token 數當作是 AI 的「大腦容量」,能處理的 token 越多,表示 AI 越不會忘記之前的對話。而 Gemini 1.5 高達 100 萬的單次 token 處理量,相當於可以處理 1 小時影片、11 小時聲音,或者超過 30 萬行的程式碼。

Google 也對 Gemini 1.5 進行許多實際測試,並製作成以下影片。

對大量訊息進行複雜推理

將阿波羅 11 號登月任務的 402 頁紀錄丟給 Gemini 1.5 Pro 處理,它可以推理文檔中的對話、事件和細節。另外在測試中也可以看到 Gemini 1.5 Pro 可以同時從圖片和文字間找出邏輯上的關聯,並做出回應。

更棒的跨模態推理

除了理解文字外,Gemini 1.5 Pro 也可以理解影片內的每個畫面。例如這個範例要求「找出從人的口袋取出一張紙的那一刻」,如果是透過人眼來看,至少也要花個幾十分鐘,但 Gemini 1.5 Pro 只花了不到 1 分鐘的時間就將這個畫面出現的時間點找了出來。

支援更長的程式碼區塊,解決複雜問題

寫程式時搭配一些 Lib 會讓系統更加龐大,但 Gemini 1.5 Pro 能一次吃下 100 萬個 token,因此對於解決更複雜的程式開發問題也有很大的改進。

效率

在同時搭配文字、程式碼、圖形、聲音、影片進行評估時,Gemini 1.5 Pro 在大型語言模型測試基準中有 87% 表現優於前一代的 Gemini 1.0 Pro;在星相同的測試基準中,效能甚至已經和 Gemini 1.0 Ultra 不相上下,也就意味著 Gemini 1.5 Pro 可以使用更少的資源得到同等的結果,更有機會在不同的運行環境下使用。

另外 Gemini 1.5 Pro 也展開了「情境學習」技能,在不需要微調的狀況下 AI 模型就能自行推理。這個試驗使用了 MTOB 基準測試,將英文翻譯成網路上少見的卡拉曼語 (Kalamang),它的學習程度和學習相同內容的人相當。

為了提高模型訓練效率,Google 也使用了新的專家混合 (MoE) 訓練架構,讓 Gemini 1.5 可以更快速的學習複雜的任務,同時也能保持訓練品質。